Contenu de l'article

Transformation numérique d'une PME de conseil RH : Comment construire un intranet sécurisé et scalable

Introduction

La transition numérique n'est pas qu'une question de technologie. C'est avant tout une question de transformation opérationnelle, de gouvernance des données, et de création de valeur pour l'organisation. Chez Novicore, nous accompagnons régulièrement des entreprises dans cette transition. Récemment, nous avons livré un projet d'intranet complet pour une PME de conseil en ressources humaines, et ce projet illustre bien les défis complexes auxquels sont confrontées les organisations en 2025.

Cet article revient sur les enjeux, les choix architecturaux, et les résultats concrets de cette transformation.

Le contexte : une PME en quête de structuration

Notre client est une PME de conseil en ressources humaines basée en Île-de-France avec environ 150 collaborateurs répartis sur trois sites (Paris, Lyon, Bordeaux). Avant notre intervention, l'entreprise fonctionnait de manière très fragmentée sur le plan informatique.

Les collaborateurs utilisaient en parallèle des mails, des partages réseaux SMB non sécurisés, SharePoint en version obsolète, et divers outils collaboratifs personnels (Dropbox, Google Drive). Les processus RH étaient semi-manuels, reposant largement sur des feuilles de calcul Excel transmises par mail. Aucune gouvernance centralisée, aucun audit trail, et une exposition importante au risque de sécurité et de non-conformité RGPD.

Les symptômes étaient classiques mais aigus :

- Les collaborateurs passaient 15 à 20 minutes à chercher une information

- Aucune traçabilité des modifications ou des accès aux données sensibles

- Les données RH confidentielles circulaient sans contrôle d'accès granulaire

- L'onboarding d'un nouveau collaborateur prenait 2 à 3 heures juste pour configurer les accès

Le client avait une vision claire : créer une plateforme unifiée, sécurisée, et conforme à la réglementation.

Les défis techniques et opérationnels

Construire un intranet moderne en 2025, ce n'est pas juste faire un site web. C'est concevoir une infrastructure capable de :

1. Gérer la sécurité à tous les niveaux

Les données manipulées (contrats, salaires, informations personnelles) sont hautement sensibles. Il ne suffisait pas d'avoir du HTTPS. Il fallait de l'authentification multi-facteurs, du chiffrement des données au repos, une gestion granulaire des permissions, et un audit trail complet pour répondre aux demandes d'accès RGPD.

2. Assurer la performance et la disponibilité

Avec 150 collaborateurs simultanés, l'intranet doit être réactif même aux heures de pointe. Les collaborateurs en télétravail en province peuvent avoir des connexions Internet limitées. Il fallait donc une architecture capable de supporter le cache, la compression, et une latence minimale.

3. Permettre l'évolution future

Le client prévoyait de croître. L'architecture devait être suffisamment modulaire et scalable pour supporter le doublement du nombre d'utilisateurs sans refonte majeure. Et il y aurait inévitablement de nouvelles fonctionnalités à intégrer.

4. Intégrer les outils métier existants

L'intranet ne devait pas être isolé. Il fallait connecter le système de paie, l'ATS (Applicant Tracking System) de recrutement, et potentiellement d'autres outils métier.

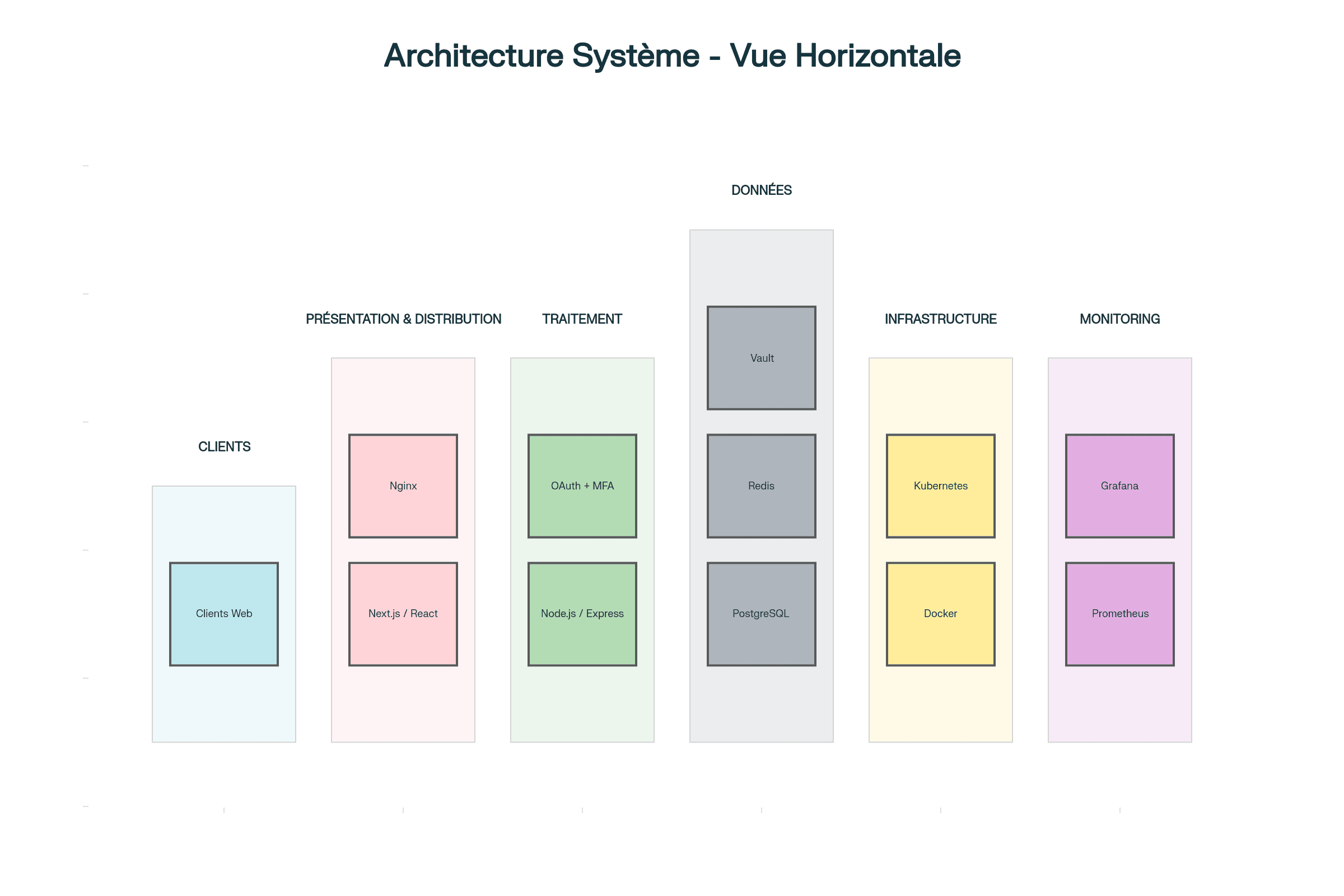

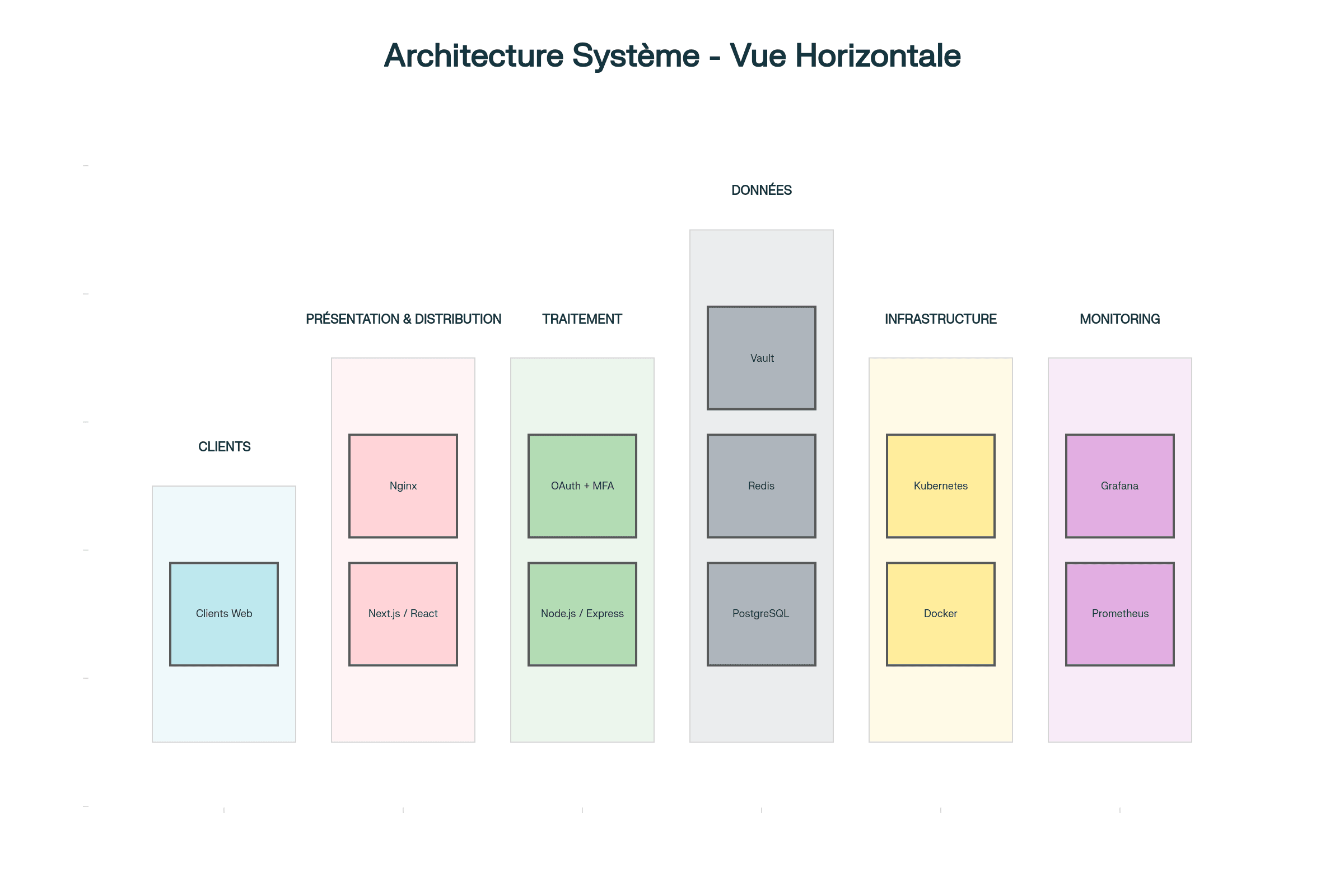

L'approche architecturale : moderne, découplée, et résiliente

Nous avons opté pour une architecture basée sur des principes éprouvés :

Stack technologique

Front-end : Nous avons choisi Next.js, un meta-framework React. Pourquoi Next.js plutôt que du React pur ? Parce que Next.js apporte beaucoup plus qu'un simple rendu côté client. Le Server-Side Rendering permet d'améliorer le SEO et les performances initiales. L'Image Optimization automatique réduit les temps de chargement. Le code-splitting est fait automatiquement. Et surtout, Next.js offre une excellente expérience développeur avec TypeScript, hot reload, et routing intégré.

Back-end : Nous avons bâti une API avec Node.js et Express. Node.js est particulièrement adapté pour les applications I/O-intensives comme une API REST. L'écosystème npm est riche, et la possibilité d'utiliser TypeScript partout (front et back) crée une cohérence et une productivité accrues.

Base de données : PostgreSQL pour sa robustesse, sa conformité ACID, et ses capacités avancées (notamment les transactions et le full-text search).

Caching : Redis pour le caching des sessions et des données fréquemment accédées, réduisant la charge sur PostgreSQL.

Infrastructure : Docker pour la conteneurisation, Kubernetes pour l'orchestration en production, et Nginx comme reverse proxy.

Principes architecturaux clés

Découplage front/back : Le front-end et le back-end sont complètement découplés. Le back-end expose une API RESTful que n'importe quel client peut consommer (web, mobile, intégrations tierces). Cela maximise la flexibilité et permet l'évolution indépendante.

API-first : Plutôt que de construire des pages serveur traditionnelles, nous avons pensé l'application en termes de ressources et d'endpoints. Cela rend le système plus testable, plus modulaire, et plus facile à monitorer.

Sécurité zero-trust : Chaque requête est considérée comme potentiellement hostile. Authentification stricte, validation de tous les inputs, permissions vérifiées à chaque appel API. Pas de confiance implicite.

Observabilité native : Dès le départ, nous avons intégré logging structuré, métriques Prometheus, traces distribuées Jaeger. Cela permet de comprendre et de diagnostiquer rapidement les problèmes en production.

Architecture front-end : au-delà du simple rendu

Next.js permet plusieurs modes de rendu selon les besoins :

- Server-Side Rendering (SSR) pour les pages critiques (tableau de bord, page d'accueil) où le SEO et la vitesse initiale importent

- Static Generation pour les pages qui changent rarement (pages d'aide, politiques)

- Client-Side Rendering pour les interfaces hautement interactives (calendrier, éditeur)

Le résultat est une expérience utilisateur fluide. Les pages se chargent rapidement, même avec une connexion limitée. Les images sont automatiquement optimisées. Et le TypeScript garantit que les erreurs de types sont détectées à la compilation.

Sur le plan de la sécurité, chaque route sensible est protégée par un middleware d'authentification qui valide le JWT et enrichit la requête avec les informations utilisateur. Les données sensibles côté front-end sont stockées uniquement dans des HttpOnly cookies, inaccessibles au JavaScript (ce qui prévient le vol par XSS).

Architecture back-end : une API robuste et maintenable

Le back-end suit une architecture en couches classique mais rigoureuse :

- Les contrôleurs gèrent les requêtes HTTP et délèguent à la logique métier

- Les services contiennent la logique métier complexe et les règles de validation

- Les repositories gèrent l'accès aux données via Prisma ORM

- Les middlewares assurent les cross-cutting concerns (authentification, logging, gestion d'erreurs)

Cette séparation des responsabilités rend le code testable, maintenable, et facilite l'onboarding de nouveaux développeurs.

Authentification multi-niveaux

L'authentification est multi-couches :

Niveau 1 : OAuth 2.0 avec OpenID Connect, intégration directe avec Azure AD ou Okta. L'utilisateur se connecte une seule fois via son fournisseur d'identité corporate.

Niveau 2 : MFA (Multi-Factor Authentication) optionnel mais fortement recommandé pour les rôles administrateurs. Implémentation TOTP (Time-based One-Time Password) compatible avec Google Authenticator ou Authy.

Niveau 3 : Sessions sans état basées sur JWT (JSON Web Tokens). Le token est signé cryptographiquement et expire après un délai configurable.

Ce modèle multi-niveaux offre un équilibre entre sécurité et usabilité. Les utilisateurs standard bénéficient du SSO transparent. Les administrateurs bénéficient de MFA pour protéger les opérations sensibles.

Gestion des données sensibles

Les données sensibles (numéros de téléphone, salaires, données biométriques) sont chiffrées au repos en base de données avec AES-256-GCM. Les clés de chiffrement sont stockées dans HashiCorp Vault, jamais dans le code ou les fichiers de configuration.

Tous les accès aux données sont enregistrés dans un audit log immuable. Cela permet de répondre aux demandes d'accès RGPD, de tracer qui a accédé à quoi et quand, et de détecter les accès anormaux.

Intégrations métier

L'intranet n'existe pas en isolation. Nous avons mis en place des connecteurs vers les outils métier existants :

- Sync avec le logiciel de paie : Les données employés sont synchronisées bidirectionnellement, évitant les doubles saisies et les incohérences

- Import depuis l'ATS : Les candidats sont automatiquement importés en tant que fiches dans l'intranet

- Webhooks personnalisés : Possibilité pour le client d'intégrer d'autres systèmes via des webhooks

Infrastructure et déploiement : DevSecOps en pratique

La construction d'une application est une chose. Son déploiement sûr, fiable et répétable en est une autre. Nous avons implémenté une approche DevSecOps complète.

Pipeline CI/CD

Chaque commit sur le dépôt déclenche automatiquement un pipeline GitLab CI :

- Linting et formatage : Vérification que le code respecte les standards de style

- Tests : Suite complète de tests unitaires et d'intégration avec couverture minimale

- Analyse statique : SonarQube détecte les bugs potentiels, et les vulnérabilités

- Scan des dépendances : Snyk identifie les librairies avec des vulnérabilités connues

- Build : Construction des images Docker

- Déploiement staging : Déploiement automatique sur un environnement de staging pour validation

- Déploiement production : Déploiement en production après approbation manuelle (gate)

Chaque étape est automatisée. Aucune intervention manuelle, aucune configuration ad hoc. Cela élimine les erreurs et rend les déploiements prédictibles.

Sécurité intégrée au pipeline

Le pipeline inclut plusieurs étapes de sécurité :

- SAST (Static Application Security Testing) : Analyse du code source pour détecter les patterns de sécurité faibles

- Scan des dépendances : Vérification que toutes les librairies utilisées ne contiennent pas de vulnérabilités connues

- Scan des images Docker : Vérification des couches d'images pour vulnérabilités

- DAST (Dynamic Application Security Testing) : Test de l'application en exécution pour détecter les failles applicatives

Tout est enregistré et peut être audité. Si une vulnérabilité grave est détectée, le déploiement est bloqué.

Orchestration en Kubernetes

En production, l'application tourne sur Kubernetes. Cela offre plusieurs avantages :

- Auto-scaling : Le système ajuste automatiquement le nombre de replicas selon la charge CPU/mémoire

- Auto-healing : Si un pod crashe, Kubernetes en redémarre un autre automatiquement

- Rolling updates : Les nouvelles versions sont déployées progressivement, avec possibilité de rollback si problème

- Gestion des secrets : Les secrets sont stockés de manière centralisée et injectés dans les pods à l'exécution

L'application peut ainsi supporter des pics de charge sans intervention manuelle et garantir une haute disponibilité (99.95% SLA).

Observabilité et monitoring

Un système complexe ne peut pas être exploité sans visibility. Nous avons mis en place une architecture complète d'observabilité :

Métriques : Prometheus collecte des métriques du système (CPU, mémoire, disque) et de l'application (latence des requêtes, erreurs, throughput). Grafana les visualise et permet des alertes.

Logs : Tous les logs sont envoyés à Loki en format structuré. Cela permet de rechercher et filtrer rapidement. Par exemple : "tous les accès à la table Users entre 14h et 15h" ou "tous les erreurs 5XX du dernier déploiement".

Traces : Jaeger trace chaque requête à travers les services. On peut voir exactement où passe le temps et identifier les goulots.

Ensemble, ces trois piliers (métriques, logs, traces) permettent au client et à Novicore de maintenir une excellente visibilité sur la santé du système.

Résultats concrets et impact opérationnel

Après 6 mois de déploiement et d'adoption, les résultats parlent d'eux-mêmes.

Productivité : Le temps moyen pour trouver une information est passé de 15-20 minutes à moins d'1 minute. Extrapolé sur 150 collaborateurs, cela représente un gain significatif en productivité.

Onboarding : Intégrer un nouveau collaborateur prend maintenant 15 minutes au lieu de 2-3 heures. Les accès sont provisionnés automatiquement selon le rôle.

Conformité : L'intranet est maintenant 100% conforme RGPD. Audit trail complet, gestion des consentements, anonymisation des données anciennes.

Sécurité : Contrôle d'accès granulaire, chiffrement des données sensibles, MFA pour les administrateurs. Les risques de fuites de données sont drastiquement réduits.

Scalabilité : L'architecture peut supporter 10x la charge actuelle sans modification majeure.

Conclusion : l'importance de bien faire dès le départ

Ce projet montre qu'une architecture bien conçue dès le départ, combinée à une approche DevSecOps rigoureuse, peut livrer un système qui est à la fois sécurisé, performant, maintenable, et prêt pour l'avenir.

Les technologies choisies (Next.js, Node.js, PostgreSQL, Kubernetes) sont des standards industriels éprouvés. Aucun choix exotique ou expérimental. Juste de bonnes pratiques mises en œuvre rigoureusement.

Chez Novicore, nous croyons que la valeur réside dans l'exécution. Choisir la bonne stack technologique c'est une chose. L'implémenter correctement, avec de bonnes pratiques de sécurité, une observabilité complète, et une culture DevOps, c'est ce qui fait la vraie différence.

À propos de Novicore

Novicore accompagne les entreprises dans leur transformation numérique. Nous concevons, développons et déployons des solutions modernes, sécurisées et scalables. Notre expertise couvre la cybersécurité, les infrastructures cloud, et le développement full-stack. Nous travaillons en partenariat avec nos clients, en comprenant leurs enjeux métier avant de proposer des solutions techniques.

Cet article vous a-t-il été utile ?

Votre retour nous aide à améliorer nos contenus